Devrait-on avoir peur de l'intelligence artificielle?

Dans La Conversation Canada je demande : sommes-nous en train de déléguer notre conception de ce qui est "vrai" aux IA?

🎯 Il est enfin sorti, mon plus récent article sur La Conversation Canada : “Grok est-ce que c’est vrai? Quand l’IA oriente notre compréhension du monde”.

🤖 Je pose l’hypothèse dans ce texte qu’en laissant la vérification des faits aux agents conversationnels, tels Grok, ChatGPT et Claude, nous sommes en voie de déléguer complètement le fardeau de la “vérité” à des IA.

J’utilise pour appuyer mon hypothèse des conversations avec Grok, mais aussi des données collectées par des journalistes et les analyses d’universitaires.

Alors que les Notes de la communauté sont de moins en moins utilisées au profit du nombre de requêtes faites à Grok, Ars Technica rapporte en juillet 2025 les préoccupations soulevées par un groupe de chercheurs des universités Stanford, Washington et MIT, ainsi que de l’équipe de X. L’étude en question aborde l’utilisation de Grok, devenu le principal rédacteur de ce qui reste des Notes de la communauté.

Pour lire le texte complet : Grok, est-ce que c’est vrai ? Quand l’IA oriente notre compréhension du monde

De quoi se réjouir : ChatGPT 5 est pire que le précédent (et que les suivants?)

Une étude du Center for Countering Digital Hate (CCDH) révèle que GPT-5, la nouvelle version de ChatGPT, génère davantage de contenus dangereux que GPT-4.0, notamment sur le suicide et les troubles alimentaires.

Le modèle aurait répondu positivement à des requêtes explicites que son prédécesseur refusait, produisant du contenu nocif dans 53 % des cas contre 43 % pour GPT-4.0. OpenAI affirme que l’étude ne reflète pas les améliorations récentes intégrant de nouveaux garde-fous et contrôles parentaux.

Cette controverse s’ajoute au lancement jugé raté de GPT-5, accusé d’être moins sûr et peu innovant.

Le CCDH dénonce une industrie qui sacrifie la sécurité des utilisateurs au profit de l’engagement et de la popularité.

Study Finds GPT-5 Is Actually Worse Than GPT-4o, New Research Finds

S’informer grâce aux robots conversationnels?

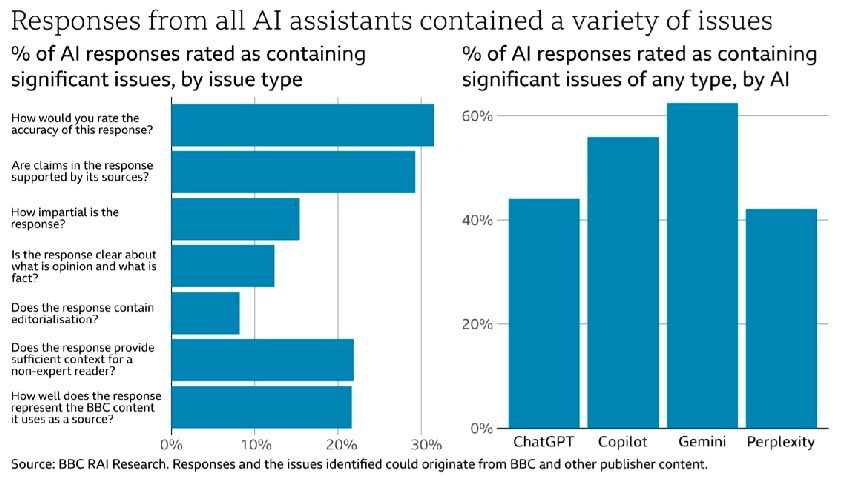

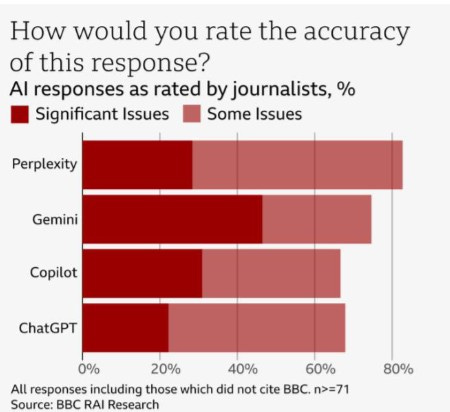

En 2024, la BBC a mené une expérience fort intéressante, s’informer sur l’actualité en consultant des chatbots. C’est ce qui qui est rapporté dans cet article du Guardian publiée en février 2025 : AI chatbots distort and mislead when asked about current affairs, BBC finds | Artificial intelligence (AI) | The Guardian

L’intérêt pour les chercheurs ou les étudiants qui souhaitent faire un travail sur ce sujet, c’est que la BBC a publié un rapport de recherche dans lequel la méthodologie employée est explicitée.

Vous pourriez donc recréer une expérience similaire. De plus, à la fin du document les exemples d’erreurs faites par les chatbot testés (voir le graphique ci-bas sur la justesse de chacun) est commentée par les chercheurs.

Document à télécharger si vous souhaitez mener des tests en classe ou au bureau.

bbc.co.uk/aboutthebbc/documents/bbc-research-into-ai-assistants.pdf

À écouter du New Yorker : Art in the Age of Artificial Intelligence

Art in the Age of Artificial Intelligence - A.I. tools are getting better at producing convincing images, text, and videos. Does that mean they can make art?

Je vous recommande aussi cet épisode du 23 octobre 2025 du balado du New Yorker sur l’art à l’ère de l’intelligence artificielle. Les trois critiques Vinson Cunningham, Naomi Fry et Alexandra Schwartz

Plutot de ceux qui savent s'en servir, surtout quand on y connait rien.

La question de la vérification des faits par les IA est effectivement cruciale, et soulèvent des enjeux importants.

Je suis d'accord qu'on ne devrait pas déléguer aveuglément la "vérité" aux IA. Mais je me demande si le problème n'est pas plus ancien que ChatGPT ou Grok. L'information biaisée n'a pas attendu l'IA pour exister.

Prenez le Guide alimentaire canadien: pendant des décennies, on recommandait 2 à 4 portions de produits laitiers par jour — en grande partie grâce au lobbying intense de l'industrie laitière. Santé Canada a fini par écarter ces groupes d'intérêt en 2019 et réduire drastiquement la place du lait dans le nouveau guide, ce qui a provoqué une levée de boucliers des Producteurs laitiers du Canada. Pendant toutes ces années, on nous disait que c'était "basé sur la science".

On a toujours dû se méfier. Des gouvernements, des corporations, des médias. L'information a toujours été filtrée, orientée, biaisée par des intérêts économiques ou politiques. Ce n'est pas l'IA qui a inventé ça — elle l'amplifie, elle l'accélère, mais le principe reste le même.

Peut-être même que le fait que l'IA soit ouvertement peu fiable va nous forcer à développer une meilleure hygiène critique. Comme Magritte avec Ceci n'est pas une pipe — toute représentation est déjà une médiation, jamais le réel lui-même. On devrait tous être sur nos gardes, IA ou pas.

Ce qui m'inquiète avec votre article (et c'est une vraie question, pas une critique), c'est: est-ce qu'on ne traite pas les humains comme des robots passifs? Comme si on allait simplement "gober" ce que l'IA nous dit sans y réfléchir? Les mêmes personnes qui savent qu'un article de journal peut être biaisé, qui vérifient sur plusieurs sources, qui doutent des politiciens — vont-elles soudainement perdre tout sens critique devant ChatGPT?

Je ne dis pas que les risques que vous soulevez n'existent pas. GPT-5 qui génère plus de contenu dangereux que GPT-4, c'est alarmant. Les chatbots qui distordent l'actualité, c'est un problème réel. Mais est-ce qu'on ne devrait pas miser sur le renforcement de l'esprit critique plutôt que sur l'idée qu'on est condamnés à croire aveuglément ces systèmes?